ИгнорироватьNEW! Сообщение отправлено: 21 сентября 2013 2:10

Сообщение отредактировано: 21 сентября 2013 2:31

[q=Игорь Нежданов]У меня СайтСпутник работает ежедневно. В среднем вытаскивает каждые сутки от 12 до 18 тысяч полнотекстовых сообщений [/q]

Очень любопытно

В связи с этим у меня к Вам ряд вопросов:

- Это в гигабайтах сколько?

- У Вас наверное очень жирный канал (сколько мегабайт в секунду средняя скорость даунлодадинга)

- Зачем Вам так много инфы? Что Вы с ней делаете-то? Или Вы просто сканируете в инет на предмет чего-то конкретного? Типа "а не появилось ли "оно"?"

- Вы согласны, что 99,9 % скаченной инфы - это шлак/мусор? Тогда зачем её качать?

[q=Игорь Нежданов] 800 ссылок это "мелочь" для программы. [/q]

Но для моего старенького компа и "тоненького" инет канала это огромная нагрузка. 18 000 веб страниц ... это примерно 5 гигабайт инфы в день.

Зачем столько? Ведь человек даже сотню страниц в день не осилит вдумчиво прочитать. Или Вы не читаете, а просто сканируете?

[q=Игорь Нежданов]800 ссылок это "мелочь" для программы. [/q]

У меня одна страница загружается в среднем за 20 секунд. 800 x 20 = 16 000 секунд. Т.е. примерно 4,5 часа потребутся программе..

Я за это время 10 раз уже успею вручную "нагуглить" то, что мне надо

Путем анализа выдачи поисковиков и модификации по результатам этой выдачи своих поисковых запросов

И вообще, ИМХО, устраивать у себя на компе мини-гугль (закачивая на хард с целью анализа десятки тысяч ссылок) - это порочная идея.

ИМХО, нужно бить интеллектуальностью, чтобы как можно меньше качать на хард не нужной инфы. А не тупо, "в лоб" качать всё что попалось

За счёт чего это можно сделать?

1) За счёт более детального анализа сниппетов выдачи поисковиков и содержимого все-таки скачанных на хард веб-страниц

2) За счёт более лучших и качественных запросов

Поэтому, ИМХО, главными задачами программы должны быть:

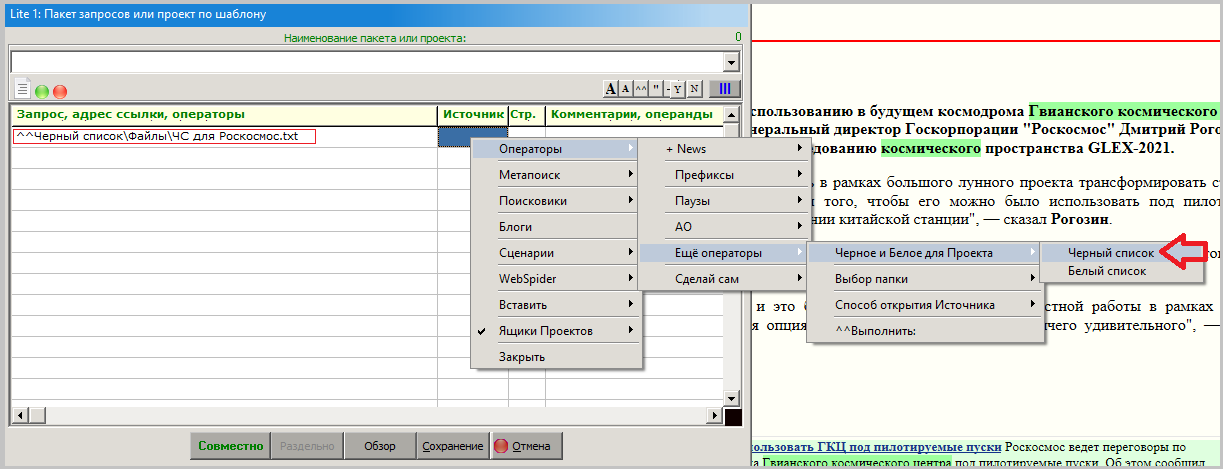

1) автоматизация анализа сниппетов и скачанных веб-страниц

2) автоматизация фильтрации "левой" информации

3) [b]автоматическое[/b] (или интерактивное в режиме "подсказка") генерирование новых "хороших" запросов по результатам анализа

Ну, это сухие эмоции.

Ну, это сухие эмоции.